AI

Published

8 feb 2026

9

-

min read

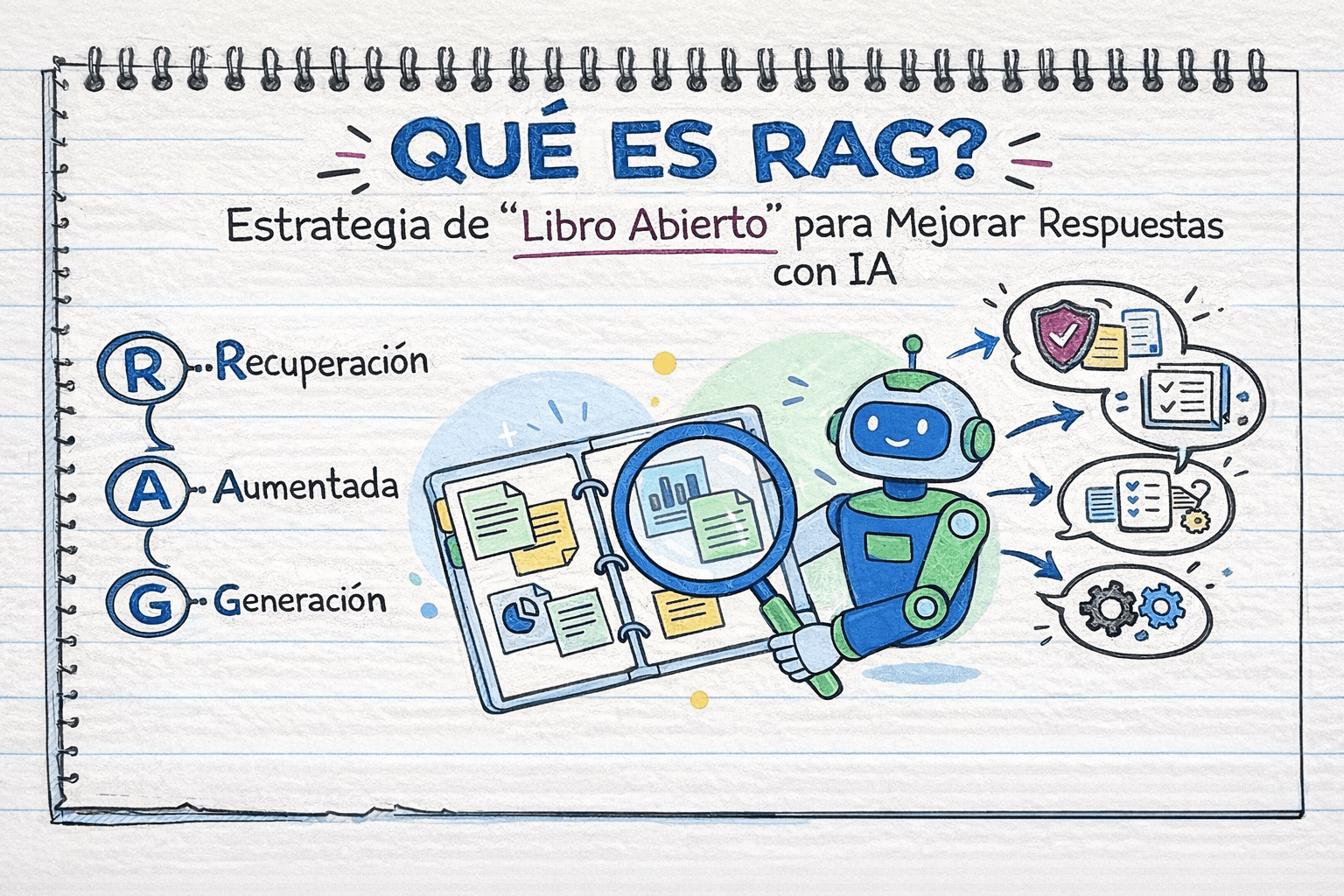

¿Qué es RAG? La Arquitectura de IA que Realmente Funciona

¿Qué es RAG? La Arquitectura que Separa la IA que Funciona de la que Solo Gasta Dinero

Mientras el 70% de las empresas que usan IA generativa ya implementaron RAG para personalizar sus modelos, el mercado global pasó de $1.96 mil millones en 2025 a proyecciones de $40.34 mil millones para 2035. Y no, esto no es otra burbuja tecnológica. Es el único sistema que realmente funciona cuando conectas IA a tu negocio.

La realidad que nadie te cuenta: las empresas gastan millones en implementaciones de IA que fallan porque ignoran un principio fundamental. Tu IA necesita acceso a información específica, actualizada y verificable. No puede inventar respuestas. No puede adivinar tus políticas internas. No puede operar con datos de hace dos años.

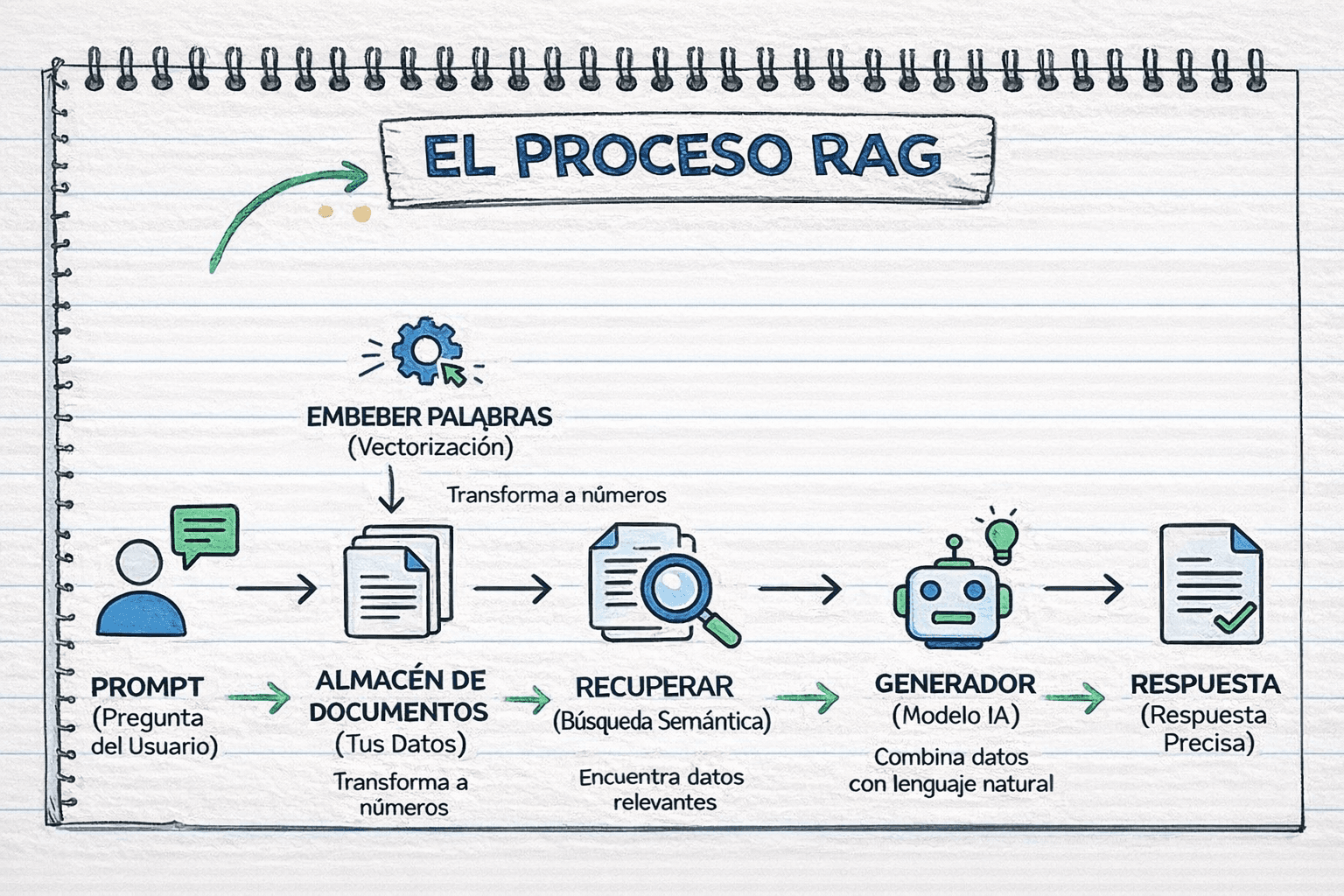

RAG (Retrieval-Augmented Generation) resuelve esto de forma simple: dale a tu IA una biblioteca organizada de tu información real, y observa cómo deja de inventar cosas.

Por Qué RAG es la Diferencia Entre Éxito y Fracaso

Hablemos con datos reales, no con promesas de vendedores.

El MIT publicó investigación sobre adopción empresarial de IA generativa y los números son brutales. Sin embargo, hay un patrón claro: las empresas que implementan RAG correctamente multiplican sus modelos en producción por 11x comparado con 2023, mientras mejoran su eficiencia de despliegue 3x.

La diferencia no está en el tamaño del modelo. Está en la arquitectura.

Las empresas aumentaron bases de datos vectoriales para RAG en 377% año con año, el crecimiento más rápido entre todas las tecnologías relacionadas con LLMs. Esto no pasa porque está de moda. Pasa porque funciona.

Aquí está la realidad: 47% de proyectos de IA llegan a producción, comparado con solo 25% de soluciones SaaS tradicionales. Pero hay trampa. Muchos proyectos técnicamente "funcionan" pero no generan el ROI esperado. El problema casi nunca es tecnológico. Es estratégico.

Las empresas que fracasan cometen errores predecibles:

Error 1: Ignorar la Diversidad de Datos Tus documentos no son uniformes. Tienes Word limpios, PDFs escaneados mal, hojas de cálculo masivas, presentaciones, código fuente, bases SQL, wikis internas y sistemas legacy. Cada fuente necesita procesamiento específico. Las empresas que subestiman esta complejidad colapsan antes de optimizar algoritmos.

Error 2: Subestimar Control de Accesos En equipos grandes, no todos tienen el mismo acceso. RAG debe respetar permisos de usuario, integrar proveedores de identidad y aplicar control de acceso rol-based. Tratar esto como "detalle técnico" genera violaciones de cumplimiento que matan el proyecto.

Error 3: Olvidar Actualización de Datos Tus documentos cambian constantemente. Versiones se actualizan, archivos nuevos se agregan, permisos evolucionan. RAG debe sincronizar frecuentemente reflejando siempre el estado actual. Sistemas con información obsoleta pierden confianza del usuario inmediatamente.

Error 4: Arquitectura Rígida Pipelines simples recuperador-generador funcionan para queries básicos pero fallan en razonamiento complejo, inferencia multi-paso y requerimientos específicos de dominio. Cuando necesitas RAG "agéntico" donde el sistema ejecuta planes dinámicos, pipelines fijos no escalan.

RAG para Emprendedores

Olvidemos manufactura y grandes corporaciones. Hablemos de cómo RAG impacta emprendedores reales.

Caso 1: Soporte al Cliente Automatizado Pequeños negocios implementan RAG para manejar consultas 24/7 sin contratar personal nocturno. Un e-commerce SME implementó asistente con RAG reduciendo tiempo de resolución 25%, mejorando resolución en primer contacto 35% y reduciendo costos de soporte 30% en tres meses. ROI positivo en 90 días.

Para emprendedores, esto significa: un chatbot que realmente conoce tus políticas, tus productos y tu inventario actual. No respuestas genéricas. Información precisa conectada a tus sistemas reales.

Caso 2: Habilitación de Ventas Equipos de ventas pierden días investigando para cada propuesta o RFP. RAG recupera automáticamente casos de éxito relevantes, especificaciones técnicas y pricing actualizado. Emprendedores reportan reducción de 45% en tiempo de preparación de propuestas.

Caso 3: Onboarding de Empleados Startups con equipos pequeños no pueden dedicar días a capacitar cada contratación. Asistentes con RAG responden preguntas sobre políticas, beneficios y procedimientos instantáneamente. HR de una persona opera como departamento completo.

Caso 4: Búsqueda de Productos E-commerce Retailers online implementan RAG para búsqueda semántica. Cliente busca "zapatos para correr en lluvia" y el sistema entiende la intención, recupera productos impermeables con tracción, no solo coincidencias de keywords. Mejoras de conversión de 15-20% son comunes.

Factores de Éxito para Emprendedores:

La diferencia entre emprendedores que triunfan con RAG versus los que gastan dinero sin retorno:

Comienza con caso de uso claro: No "mejorar productividad". Define "reducir tiempo de procesamiento de facturas de 8 días a 2 días manteniendo 99.5% de precisión".

Usa herramientas diseñadas para SMB: Plataformas SaaS con RAG integrado versus construir desde cero. Microsoft Dynamics 365, Workable, Breezy HR y otras ofrecen capacidades RAG accesibles.

Capacita a tu equipo: RAG no es "instalar y olvidar". Es incorporar un empleado nuevo. Presupuesta para entrenamiento, iteración y mejora continua.

Mide resultados reales: Define métricas antes de implementar. Rastrea mejoras específicas, no percepciones.

El punto crítico: emprendedores logran ROI positivo en 2-3 meses, especialmente en dominios donde precisión de respuestas impacta directamente resultados de negocio. No necesitas infraestructura enterprise. Necesitas claridad estratégica.

RAG vs Fine-Tuning vs Context Windows Largos

Ahora viene la pregunta que todos hacen: "¿Si los modelos nuevos tienen contextos gigantes, para qué necesito RAG?"

Gemini 3 Pro soporta hasta 1 millón de tokens. Llama 4 Scout anuncia hasta 10 millones. GPT-5.2 ofrece hasta 400,000 tokens. ¿

Esto hace RAG obsoleto?

No. Y aquí está exactamente por qué con números reales.

Comparativa de Velocidad: Un pipeline RAG promedia 1 segundo end-to-end para queries. Configuración con contexto largo toma 30-60 segundos en la misma carga. Otro experimento midió decenas de milisegundos para búsqueda vectorial en RAG versus sistemas con contexto largo reportando latencias de minutos cuando contextos se acercan a cientos de miles de tokens.

Para aplicaciones interactivas requiriendo respuestas bajo 2 segundos, pipelines RAG optimizados cumplen consistentemente. Contextos largos luchan por lograrlo.

Comparativa de Costos: Con RAG, pagas por: embedding de queries, recuperación de chunks relevantes, generación con esos chunks en contexto (típicamente pocos miles de tokens).

Con contexto largo, pagas por token por todo en la ventana. Si necesitas 100,000 tokens de contexto, pagas por todos en cada request.

Benchmarks reales:

Modelo Base: $11 por 1,000 queries

Modelo Fine-Tuned: $20 por 1,000 queries

Base + RAG: $41 por 1,000 queries

Fine-Tuned + RAG: $49 por 1,000 queries

Pero estos números engañan sin contexto. RAG parece más caro, pero esos $41 asumen recuperar contexto completo cada vez. Con caché semántico, queries similares retornan respuestas cacheadas sin llamar al LLM. Contexto largo paga por 100,000 tokens repetidamente.

Trade-off Fundamental: RAG: permite recuperación en tiempo real de información más reciente con actualizaciones flexibles de base de conocimiento pero incurre costos más altos por inferencia.

Fine-tuning: entrega costo-por-inferencia superior para dominios estables pero requiere ciclos costosos de reentrenamiento cuando conocimiento cambia significativamente.

Para industrias rápidas con cambios regulatorios frecuentes o documentación evolutiva, flexibilidad de RAG ahorra tiempo y dinero a largo plazo. Para dominios con conocimiento especializado estable que cambia raramente, fine-tuning eventualmente entrega economía superior a pesar de inversión inicial más alta.

Comparativa de Calidad: Ambos enfoques produjeron respuestas idénticas para aproximadamente 60% de preguntas en evaluación a través de 12 datasets de QA.

Rendimiento divergió en casos restantes:

Contexto largo mostró ventaja para tareas requiriendo razonamiento completo a través de documentos enteros

RAG tuvo mejor desempeño para recuperación factual precisa con atribución de fuente

Esta divergencia refleja características arquitectónicas fundamentales: modelos de contexto largo desarrollan comprensión holística de documentos completos a través de mecanismos de atención abarcando contexto entero, mientras sistemas RAG optimizan para precisión enfocando atención del LLM en pasajes específicamente relevantes.

El Patrón Emergente 2026: Las mejores implementaciones combinan RAG y contexto largo estratégicamente:

Embeben resúmenes de documentos para eficiencia de recuperación pero los vinculan a documentos completos que cargan en ventanas de contexto extendidas cuando se necesita análisis más profundo

Recuperan chunks enfocados para evaluación inicial mientras mantienen enlaces a documentos fuente completos para contexto más profundo cuando se requiere

Esto crea sistemas que operan eficientemente para queries simples pero escalan a análisis comprehensivo cuando el negocio lo justifica.

Tendencias RAG 2026 y Evolución Futura

La evolución de RAG en 2026 se concentra en maduración práctica más que breakthroughs tecnológicos.

Tendencia 1: RAG Agéntico Solo 16% de implementaciones enterprise y 27% de startups califican como verdaderos "agentes" donde un LLM planea y ejecuta acciones, observa feedback y adapta comportamiento. La mayoría siguen construidos alrededor de flujos de secuencia fija.

RAG agéntico rompe esto. En lugar de recuperar una vez y generar una vez, el sistema:

Descompone requests en múltiples pasos

Encuentra tendencias de fuentes confiables

Compara datos actuales contra líneas base históricas

Verifica inconsistencias o vacíos

Sintetiza todo en respuestas accionables

Impacto de negocio: automatización real de tareas analíticas complejas. El sistema no solo responde preguntas, ejecuta acciones via APIs: envía emails, actualiza sistemas, genera reportes.

Tendencia 2: RAG Multimodal RAG tradicional opera casi exclusivamente en documentos basados en texto. Empresas cada vez más almacenan conocimiento en formatos diversos: PDFs con imágenes, documentos escaneados, diagramas de productos, dashboards BI, logs multimedia, videos de demostraciones.

RAG multimodal integra embeddings de imagen, audio, tabular y video creando capacidades de razonamiento más holísticas. Implementaciones en healthcare muestran valor concreto: reducción de 30% en diagnósticos erróneos para casos complejos, disminución de 25% en tiempo que doctores gastan revisando literatura, aumento de 40% en detección temprana de enfermedades raras.

Tendencia 3: GraphRAG RAG tradicional trata información como chunks aislados, perdiendo conexiones entre entidades que dan profundidad y contexto a respuestas. GraphRAG cambia esto combinando knowledge graphs con modelos de lenguaje, permitiendo a IA razonar a través de datos vinculados, rastrear relaciones y producir respuestas más ricas y precisas.

El desafío: extracción de entidades, deduplicación y resumen de comunidades consumen varias a docenas de veces más tokens que texto original. Entidades y relaciones extraídas automáticamente contienen ruido, redundancia o errores significativos comparados con knowledge graphs diseñados meticulosamente y curados por expertos de dominio.

A pesar de desafíos de implementación, ventajas de GraphRAG para queries complejos justifican desarrollo e inversión continuos. Organizaciones reportan capacidad mejorada para descubrir relaciones y conexiones indirectas que recuperación tradicional basada en vectores pierde.

Tendencia 4: Privacidad y Cumplimiento Preocupaciones de privacidad y cumplimiento emergen como diferenciadores críticos en selección de plataformas RAG conforme regulaciones se endurecen globalmente.

Sin embargo, cumplimiento de privacidad no presenta meramente obstáculos sino paradójicamente crea ventajas competitivas para arquitecturas RAG bien diseñadas. Las directrices del DSK de octubre 2025 sobre temas de ley de protección de datos relacionados con sistemas RAG concluyeron que RAG puede tener impacto positivo significativo en cumplimiento de privacidad, particularmente respecto a principios de precisión, transparencia y legalidad.

Al aprovechar información de fuentes adicionales más allá de la base de conocimiento del LLM, output de RAG debe ser más actualizado y específico al contexto, reduciendo riesgo de inexactitud y alucinación—sirviendo directamente el principio de precisión. La capacidad de citar fuentes recuperadas e identificar orígenes de información sirve directamente requerimientos de transparencia y explicabilidad.

Conclusión

RAG no es tecnología experimental. Es infraestructura empresarial esencial con mercado proyectado de $40+ mil millones para 2035 y 70% de organizaciones usando RAG para personalizar LLMs.

La brecha entre potencial técnico de RAG y éxito de implementación organizacional permanece sustancial. Implementaciones exitosas logran resultados extraordinarios: mejoras de eficiencia de soporte al cliente de 25-40%, aceleración de recuperación de información de 3-5x, automatización de cumplimiento ahorrando millones anualmente y mejoras de calidad de decisión traducidas a impacto de negocio medible.

La diferencia no radica en sofisticación tecnológica sino en disciplina organizacional: métricas claras de éxito, modelos de partnership apropiados, arquitectura lista para producción, enfoques que priorizan gobernanza y compromiso con mejora continua.

Las organizaciones que abordan RAG con expectativas realistas, modelos de partnership apropiados y compromiso con resultados medidos capturarán ventaja competitiva significativa a través de toma de decisiones más rápida, experiencia de cliente mejorada y eficiencia operacional.

Aquellos que tratan RAG como otro despliegue de software en lugar de infraestructura estratégica requiriendo cambio cultural y organizacional probablemente experimentarán decepción de piloto. La tecnología en sí ha probado ser efectiva; el desafío que permanece en 2026 involucra ejecución organizacional igualando capacidad técnica con disciplina de negocio y compromiso estratégico.

___

Aldo Vereteramo

av@avoficial.com